Stable Concussion, la guerra de los artistas contra las AI

Desde que empecé a investigar sobre Inteligencia Artificial y entender este mundo tan particular aparecieron voces contrarias, con o sin sentido, reacciones, espasmos, algo que hemos visto ante otras tecnologías, pero esta vez con un condimento particular.

En particular, me refiero, a que hay algo de razón. Para entrenar una AI es necesario usar material existente, previo, sea texto o imagen, que "enseñe" a ese modelo matemático qué es un perro o un gato, y para hacerlo hace falta mucho contenido.

¿De dónde sale? Ahí es donde los artistas elevan el grito, pero ¿Tienen razón? y más aun ¿Pueden evitarlo?

Cómo se entrena una AI

Para entrenar un modelo, por ejemplo, generativo de imágenes, es necesario proveer al sistema de entrenamiento de una gran cantidad de imágenes y sus correspondientes tags o metadatos que la describen.

Con cientos podemos entrenar un modelo muy básico y primitivo, con miles mejora, con millones ya va queriendo, con miles de millones es como se obtiene un modelo en la actualidad.

El proceso de creación de un modelo es costoso, no sólo por el enorme banco de imágenes catalogadas sin errores, sino por tiempo de procesador. No es algo que puedas hacer en tu casa, se requieren múltiples GPU industriales (no los gamers que podemos pagar), duarnte días, diseccionando cada imagen en matrices numéricas y algoritmos.

Nada de lo original queda en el modelo final, es un archivo puramente numérico, matemático, que comprime el "conocimiento" creado a partir de múltiples pasos que hace por cada imagen.

Por esta razón sus creadores dicen que no hay plagio alguno, porque no guarda ninguna imagen, sólo el conocimiento suficiente para crearlas y combinarlas.

Si entrenamos un modelo con muchas imágenes de artistas y le pedimos luego exactamente uno, creará una "versión" de la obra "basada" en la combinación entre el pedido y lo que entrenó. Si le pedimos que dibuje algo de Da Vinci, si especificamos que sea la Gioconda, no creará una reproducción 100% fiel del cuadro pixel a pixel sino una versión de lo que pudo entender, resumir y comprimir en el modelo.

Pero el resultado será el cuadro de Da Vinci. ¿Inspiración o copia?

La reacción reaccionaria

Personalmente, aquí emito opinión, mi primer reacción contra los reaccionarios fue porque sabía perfectamente que no entendían ninguno de los procesos involucrados para entrenar una AI.

No hace falta para entenderlo, si alguien le pide a una AI "haceme un cuadro al estilo de Fabio" y el resultado es particularmente similar a mis obras, no necesito entender cómo funciona por dentro para sentirme violado. Siento que hay plagio automáticamente.

Por esto tenemos que ponernos en un punto de vista más empático con el que se siente plagiado, a veces te plagian (como blogger lo he visto mucho en otras épocas), a veces dos personas tuvieron la misma inspiración (un trigger le llego a los dos a la vez), a veces publican algo con poca diferencia de tiempo (el ejemplo clásico es la invención del láser), y así.

Pero cuando es una computadora, no un humano, quien "crea" eso, no pensamos ni en inspiración ni coincidencia, y nos revuelve, es inevitable.

Hay en curso varias demandas colectivas contra los primeros creadores de modelos, sea ChatGPT (OpenAI), MidJourney, StableDiffusion y otros, basados en una idea concreta: nadie le pidió permiso a los autores para usar sus obras en el entrenamiento de sus modelos.

¿No es así como se aprende?

Aquí empieza la discusión filosófica (que usualmente no lleva a ningún lado) de ¿No es así como aprende cualquier artista su arte? ¿Acaso estamos libres de influencia alguna?

No hay artista que no haya sido influenciado por otro artista o por cosas que ha visto y/o sentido, sacando excepciones muy extrañas, la casi totalidad se basa en lo que consumió durante años hasta que se animó a crear y luego lo que siguió incorporando hasta que crea lo que llamamos su "estilo propio", que usualmente se "parece" a otros, nadie está libre de influencias, todo es un remix.

Pero, quieras o no, el estilo de algunos es más reconocible que el de otros, el estilo empieza a volverse moda, pero no hay dos artistas famosos con exactamente el mismo estilo, siempre hay diferencias, es a lo Highlander, sólo sobrevive uno. No hay dos Van Gogh, está Van Gogh y el que imitaba a Van Gogh que ya nadie recuerda.

El ego entre los artistas es todo, su estilo también, es la escencia, lo que los hace "únicos", ser fácilmente reproducidos por una máquina que no sabe por qué hace lo que hace (AI le queda grande, es Machine Learning, nada más) los destruye.

Del otro lado le van a responder "pero así son todos los artistas, unos copiones donde apenas uno tiene algo de talento". Bueno, en muchos casos tienen razón, de hecho, los más quejosos que he visto en redes sociales son estos sin-talento quejándose al darse cuenta que el mundo que soñaron, uno donde los mediocres podían hacer uso de la escacés para hacerse de una vida, ven el sueño desvanecerse 😁

Aun así muchos de los que se quejan son grandes artistas, reconcidos, ven que todo su esfuerzo puede ser reemplazado por dos clicks y quieren o prohibirlo o una tajada de la torta y ven que unos pocos están aprovechando sus creaciones para alimentar una máquina que nadie entiende, pero que genera dividendos.

Lo difícil de probar

El problema aquí está en dos cosas que en el ambiente se conocen muy bien, primero probar que una obra fue realmente vulnerada, la segunda en poder dar una trazabilidad de qué obra está usando una AI para "inspirarse".

El primero es demostrable en algunos escenarios en particular, hubo varios experimentos forzando los prompts para llegar a un resultado esperable... y se consiguió. Es decir, con suficiente inteligencia y los condicionamientos justos es posible lograr que una AI entregue como resultado una obra casi casi idéntica al original que usó para su entrenamiento. Por ende así se puede probar qué imagen se usó para entrenar.

Si las diferencias son demasiadas es más difícil, pero en la medida en que los creadores de modelos mejoraron y purificaron sus resultados, volviéndolos casi fotográficos, el resultado se acercó demasiado a la obra original. En la lucha por mejorar el producto se fueron cavando la propia fosa.

El problema sigue siendo el mismo para todos, distinguir qué y de dónde proviene: el año pasado un grupo de artistas, Sarah Andersen, Kelly McKernan, Karla Ortiz, Hawke Southworth, Grzegorz Rutkowski, Gregory Manchess, Gerald Brom, Jingna Zhang, Julia Kaye, y Adam Ellis demandaron en conjunto a Stability AI, DeviantArt, Midjourney y Runway AI (sitio oficial de la demanda).

En los sets utilizados para entrenar que provee LAION, una organización abierta, encontraron sus propios trabajos. LAION es un dataset libre ya catalogado y organizado que se utiliza para crear modelos. En este caso tan particular resulta fácil de probar que la imagen de X artista fue utilizada para entrenar el modelo porque allí está libremente expuesto. Los datasets LAION-5B y LAION-400M no ocultan nada de esto (son libres y abiertos), pero los artistas niegan otorgar permiso. (ejemplos)

Esto obligaría a esas empresas a re-entrenar los modelos exceptuándolos y pagar por los supuestos "daños", ahora lo difícil también es probar esto otro. En su demanda presentan justamente ejemplos pidiéndole a distintos sistemas un prompt similar al dato que está en el dataset con el nombre del artista, el resultado es... muy similar. (ejemplos)

Bajo la misma idea los de Getty Images, que cobran por cada imagen que tienen en stock (son un banco de imágenes) demandó a Stability AI al identificar similitudes demasiado obvias con fotos de su catálogo. Básicamente ante ciertos prompts encontraron que aparecía su propia y odiable marca de agua! 😁

De abierto a privado

Uno de los temas interesantes de todo esto, y que es un buen argumento, es que mucho de lo que se usa para entrenar estos modelos se toma de contenido público, abierto y libre, no necesariamente sin copyright, me refiero a "consumible", coleccionado mediante spiders similares a los que utilizan los buscadores.

El contenido abierto es procesado, transformado y convertido en un modelo cerrado y privativo. Violando así las reglas del contenido usado para entrenar.

Por ejemplo, el contenido mismo de este blog ha sido tomado sin permiso (no lo requiero) por spiders de distintos productos AI, luego procesados y transformados, puestos detrás de un paywall y que ahora piden dinero a cambio de resultados (algo que mi licencia sí requiere, al menos, avisar).

Es decir, a diferencia de Stability AI, Meta o Mistral u otros modelos abiertos, empresas como OpenAI o MidJourney tienen modelos cerrados, no es un "tomo del mundo, devuelvo al mundo", sino un "tomo del mundo, le vendo al mundo", y esto no tengo ninguna duda que a más de uno le está molestando y con razón.

¿Se está tomando el conocimiento humano para cerrarlo y bloquear el acceso? Las empresas más grandes y poderosas están coleccionando toda la información, creando modelos cerrados y luego ¿creando nuevos jardines vallados desde donde cobrarnos por usarla? Es otra de las discusiones que poco se está dando, pero que debería tener mayor atención.

Uno de los argumentos más usados por estas empresas es que nos van a liberar, solucionar la vida y/o ayudar al mundo/humanidad, pero ¿Dónde vemos estos resultados? Hasta ahora por ningún lado.

Los Luditas

Allá en el tiempo, al comienzo de la revolución industrial, comenzó un movimiento anti-industrialista de artesanos ingleses. Los Luditas.

Su reacción fue contra la baja calidad y velocidad de producción de los telares industriales, su reacción fue destruir los telares ya que ellos no podían llegar a los niveles productivos de forma manual, no querían a una máquina reemplazando su trabajo.

No es que se opusieran en sí a una mejora social y/o máquina en particular, se oponían a cambiar su forma de vida forzosamente. Desde aquellos primeros luditas del siglo XIX han surgido nuevos luditas a cada cambio tecnológico.

Cuando el automóvil apareció la reacción de los criadores de caballos fue totalmente racionalizada, cuando la electricidad empezó a llegar los balleneros reaccionaron también (el aceite de ballena se usaba para las lámparas) aunque las ballenas respiraron aliviadas al evitar su extinción 😅

No es raro encontrar todavía algún viejo quejándose de las computadoras o los teléfonos celulares porque "en mi época ñañañá", ¿Estamos ante un escenario similar con la AI?

¿Es acaso el artista quejoso contra la AI un ludita del siglo XXI? O, más bien, ¿nos está advirtiendo de una futura extinción del artista como creador de cosas nuevas? ¿Es el ballenero contra la electricidad o es la ballena que estaba siendo diezmada?

Tengo cierta aversión contra el que pretende vivir del arte sin hacer nada más, no por su arte, sino porque el que lo pretende suele ser un mediocre pretencioso y nada más. Pero ese es mi prejuicio personal, no creo que todos sean así.

La semana pasada discutí con varios pseudo-artistas (a ninguno lo considero tal) y sus reclamos contra la AI eran más bien básicos y primitivos "roba", "es plagio", pero sin elaboración alguna.

La discusión se disparó porque una librería avisaba que no vendería ningún libro ilustrado o redactado por una AI. Como si pudiera, desde el punto de vista del lector, darse cuenta cuándo un libro está escrito por una máquina o por un mediocre autor. La imagen que citaban era tan mala y vaga que entiendo al autor de la queja (primer prompt sin refinar, vagos), pero ¿Acaso las portadas de los libros son todas obras de arte? Siempre hubo muy malas y vagas.

Darte cuenta si fue escrito por una AI puede ser imposible, si un libro está bien editado y supervisado, si el contexto que se le da a la LLM está bien detallado, es muy difícil que identifiquen un libro como de autoría total o parcial por una AI. De hecho, puedo apostar que la gran mayoría de los que vemos publicados este año tienen partes escritas y/o re-redactadas por una AI.

Esa estupidez reaccionaria no me hace sumarme a su queja sino que me provoca una reacción opuesta, los veo como Luditas ciegos y no como Luditas visionarios que nos están mostrando un camino correcto. El problema de que tus luchas las lleve adelante un fanático dogmático cuasi religioso no ayuda en nada a la causa.

Pero ¿Están los neo-luditas completamente equivocados? Se suponía que la AI venía a quitarnos los trabajos aburridos y repetitivos y dejarnos tiempo para los más interesantes, las artes iban a quedar para la humanidad y la fábrica para la máquina.

En cambio estamos presenciando el uso de la AI para redactar, escribir novelas, guiones, hacer música, crear imágenes, inventar obras, etc. Eso sí, dar vueltas hamburuguesas es todavía más barato con un humano.

Algunos lo ven como una "democratización hacia el que no tiene talento alguno" y otros como una "afrenta contra el que sí tiene talento".

El contraataque cultural

Y para ir cerrando este kilométrico pseudo-ensayo, quería comentarles sobre el "Data Poisoning" que se está poniendo de moda a partir de las AI generativas.

Se trata de "ensuciar" la versión digital de trabajos de autores con pequeñas modificaciones que rompen el proceso de entrenamiento de las AI.

Un ejemplo de esto es Glaze, un proyecto de la Universidad de Chicago, que permite procesar las imágenes para modificarlas levemente.

La idea es confundir el entrenamiento y que el resultado sea una deformidad total, así si alguien pide a una AI "dibujame un gato al estilo de Fabio" el resultado sea un perro totalmente deforme, que no tenga nada que ver.

Los algoritmos son vulnerables a la entrada "sucia" de datos, así que se los puede usar para romper el resultado entendiendo cómo son entrenados (y más o menos todos se entrenan de la misma forma).

La diferencia entre una imagen normal y una "glazed" es imperceptible para el ojo humano (dependiendo de cómo es la imagen original, en algunos casos se nota mucho),

De esta forma los artistas más modernos podrán "proteger" su obra de los más recientes catálogos para modelos... hasta que alguien agregue un pequeño filtro en su spider y "transforme" las imágenes de vuelta a algo consumible.

Es que por más que inventes hoy esta forma de "protección" siempre estarán un paso atrás, si uno realmente quiere joderlos, es trivial.

El punto aquí será ¿Cómo se definirá esto? ¿Algún juez ordenará remover las X imágenes de los Y artistas de Z modelo? ¿Cómo podría forzarlo? En un mundo tan amplio y diverso judicialmente, veo casi imposible la implementación de este tipo de fallos.

Y súmenle algo, cualquiera puede entrenar un modelo con lo que quiere, sólo tiene que crear su propio catálogo de imágenes bien seleccionadas.

No hay un fin cercano para este asunto, por eso dejo más preguntas que respuestas, porque no hay algo definitivo ni concreto, hay una acción, una reacción, luditas y tecnócratas, pero ninguno parece tener la razón y posiblemente nunca la tengan.

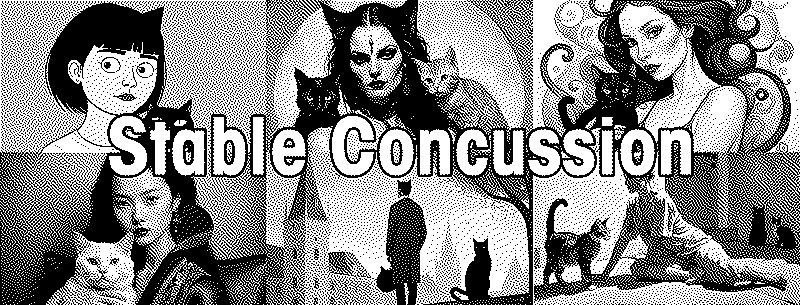

PS: Las imágenes que adornan el post fueron creadas utilizando ComfyUI con el modelo AlbedoBaseXL (basado en SDXL), con el prompt "a person and a cat in the style of " y el nombre de algunos de los artistas visuales que realizaron la demanda mencionada en el artículo. ¿Se animan a adivinar cuál es cual? Les dejo un tip:

Este artículo es parte de una serie de artículos similares que he estado escribiendo opinando sobre las ventajas, desventajas y mitos alrededor de las Inteligencias Artificiales que actualmente se están utilizando.

Stable Dellusion: ¿Tu trabajo desaparecerá catastróficamente por una Inteligencia Artificial? Unstable Diffusion - AI pero para el sexo Por qué no es buena idea usar una AI como argumento o fuente de información