Tu propio asistente AI tipo "Copilot" para programar, pero local

El otro día estaba viendo qué posibilidad tenía de usar un asistente de AI para Visual Studio Code, además de Copilot, y me encontré con un ejemplo como Cursor que, por 20 dólares, me resulta carísimo.

No es que nadie lo necesite, pero pedirle a una AI que haga las tareas más simples y aburridas de programación es ideal, no queriendo pagar un centavo, porque pobre, decidí probar otra opción: mi propia AI.

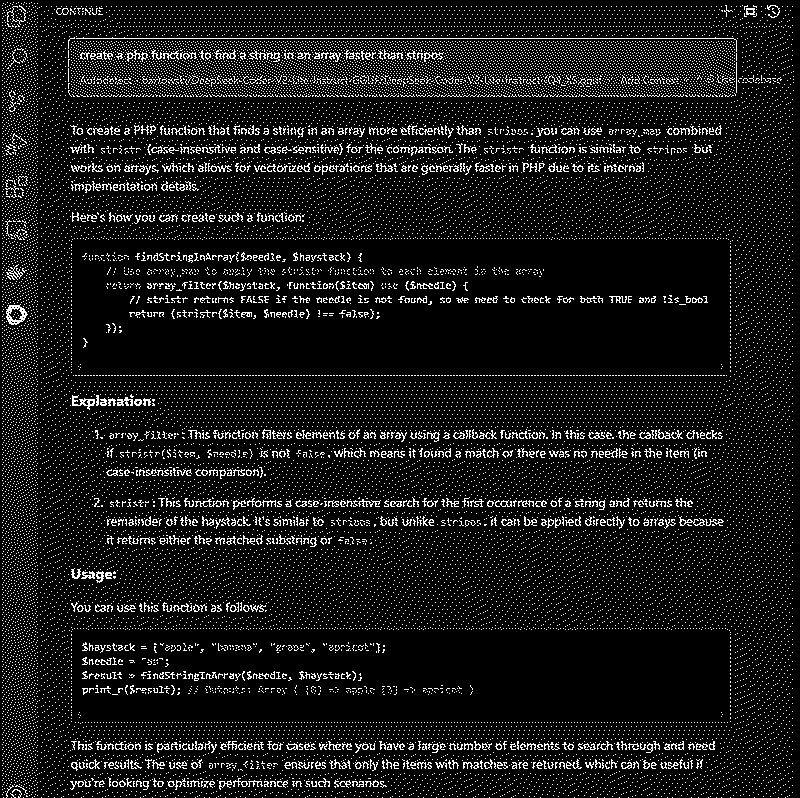

Continue

Encontré una extensión para VS Code que resuelve prácticamente todo, Continue.

Esta me permite conectarme con cualquier API y si estoy ejecutando LM Studio de forma local, puedo habilitar la API de éste y usar el modelo que quiera. Estoy hablando de ejecutar AI en tu propia PC!

Si no saben qué es LM Studio es porque les debo una nota al respecto, es una herramienta para ejecutar modelos de AI de forma local, hice un video aquí, pero se que más de uno de ustedes odia ver videos 😋así que debería escribir todo eso que dije en el mismo.

Con Continue puedo conectar un universo con el otro, mediante la API abierta de LM Studio y esta extensión podemos crear el vínculo y tener incorporado en VS Studio una AI a la que podremos preguntarle todo.

Continue también nos permite conectarnos con cualquier API desde ChatGPT a Claude, no es que está limitado a una en particular, pero ya viene preconfigurado para las más conocidas.

Cuestión de modelo

Limitaciones? Unas cuantas, porque los modelos que podemos ejecutar de forma local son más bien pequeños. Los modelos grandes, de más de 400 billones de parámetros, sólo se pueden ejecutar en grandes servidores, a nivel local tenemos que bajar a lo que entre en la memoria de nuestra placa de video.

Aquellos pocos que gozan de una 4090 con 24GB de RAM podrían aprovechar los modelos de 70 billones de parámetros, los miserables como yo tienen que apelar a modelos de no más de 8 billones de parámetros cuantizados en 4 bits con suerte (tengo 6GB de VRAM), lo que baja notablemente la calidad de las respuestas.

Hay modelos para elegir, algunos preparados especialmente para código, recomiendo esos en este caso, usar Meta Llama 3.2 para conversación no tiene sentido, hay que bajar el modelo "Code" que hay disponible.

¿Cual elegir? Pues van a tener que hacer las pruebas ustedes mismos, yo apenas pude probarlo para escribir este post y luego me fui de vacaciones 😁

Se que Code Llama puede servir bien, Stable Code también, Gemma y Phi tienen modelos para este escenario, también hablan bien de DeepSeek Coder, pero no probé ninguno en serio como para que me resolviera cosas en local.

¿Tienen alguno preferido para codear? Desde ya que usar uno de los "pagos" es mucho mejor en resultado final, todo esto que menciono es open source y libre, por lo tanto los modelos no son tan potentes, pero no por eso son despreciables.